| Разработчики: | Nvidia (Нвидиа) |

| Дата премьеры системы: | 2017/05 |

| Дата последнего релиза: | 2021/06/28 |

| Технологии: | Cloud Computing, Серверные платформы, Центры обработки данных - технологии для ЦОД |

Содержание |

Основные статьи:

2021: Nvidia A100 80G PCIe, Nvidia NDR 400G InfiniBand, Nvidia Magnum IO

28 июня 2021 года компания NVIDIA объявила о приросте платформы NVIDIA HGX AI благодаря современным технологиям, которые объединяют ИИ с высокопроизводительными вычислениями, чтобы сделать вычисления доступнее для еще большего числа индустрий.

По информации компании, чтобы приблизить приход эры промышленных ИИ и HPC-приложений, NVIDIA добавила три ключевых технологии в платформу HGX: GPU NVIDIA A100 80GB PCIe, сетевые технологии NVIDIA NDR 400G InfiniBand и ПО NVIDIA Magnum IO GPUDirect Storage. Вместе они обеспечивают экстремальную производительность для промышленных инноваций.

На июнь 2021 года Atos, Dell Technologies, Hewlett Packard Enterprise (HPE), Lenovo, Microsoft Azure и NetApp и еще десятки партнеров используют платформу NVIDIA HGX для создания систем и решений.

Платформу HGX использует компания, специализирующуюся в области высоких технологий в промышленности General Electric: компания применяет достижения в HPC для симуляций в области вычислительной динамики жидкостей (CFD) и разработки крупных газовых турбин и реактивных двигателей. Платформа HGX получила ускорение на порядок и может применять CFD-методы в коде GE GENESIS. Он использует метод крупных вихрей для изучения эффектов турбулентных потоков внутри турбин, которые состоят из сотен отдельных лопастей со сложной геометрией.TAdviser выпустил Гид по российским операционным системам

Платформа HGX также оптимизирует научные HPC-системы во всем мире, включая суперкомпьютер следующего поколения в Университете Эдинбурга, о чем также объявлено 28 июня 2021 года.

Графические процессоры NVIDIA A100 Tensor Core обеспечивают обеспечение HPC-вычислений для решения сложных задач ИИ, анализа данных, обучения моделей и симуляций в промышленности. Графические процессоры A100 80ГБ PCIe располагают на 25% более широкой полосой пропускания по сравнению с A100 40ГБ - до 2ТБ/с - и снабжены 80ГБ скоростной памяти HBM2e.

Объем памяти A100 80ГБ PCIe и широкая полоса пропускания позволяют хранить в памяти больше данных и более крупные сети, минимизируя коммуникации между узлами и снижая энергопотребление.

A100 80ГБ PCIe основан на архитектуре NVIDIA Ampere, которая поддерживает технологию Multi-Instance GPU (MIG) для ускорения небольших рабочих нагрузок, таких, как инференс. MIG позволяет HPC-системам оптимизировать объем вычислений и объем памяти. В дополнение к PCIe есть четырех- и восьми-модульные конфигурации NVIDIA HGX A100.

Партнерами NVIDIA по системам A100 80GB PCIe стали Atos, Cisco, Dell Technologies, Fujitsu, H3C, HPE, Inspur, Lenovo, Penguin Computing, QCT и Supermicro. Платформа HGX на базе графических процессоров A100 с коммутацией NVLink также доступна через облачные сервисы от Amazon Web Services, Microsoft Azure и Oracle Cloud Infrastructure.

Системы HPC, для которых требуется определенная скорость передачи данных, усилены NVIDIA InfiniBand – полностью разгружаемым интерконнектом, поддерживающим сетевые вычисления. NDR InfiniBand масштабирует производительность для решения сложных задач на промышленных и научных HPC-системах. Системы коммутации с фиксированной конфигурацией NVIDIA Quantum-2 имеют 64 порта со скоростью передачи NDR 400Гб/с InfiniBand на порт (или 128 портов по NDR200).

Модульные коммутаторы NVIDIA Quantum-2 могут иметь до 2048 портов NDR 400GГб/с InfiniBand (или 4096 портов NDR200) с общей пропускной способностью в обоих направлениях 1.64 петабит в секунду, что в 5 раз выше, чем у предыдущего поколения. У коммутатора с 2048 портами в 6.5 раз выше масштабируемость по сравнению с предыдущим поколением, и он способен подключать свыше миллиона узлов в три шага с помощью топологии сети DragonFly+.

Третье поколение технологии сжатия данных NVIDIA SHARP In-Network Computing оптимизирует производительность промышленных и научных приложений с 32-кратным ускорением ИИ по сравнению с предыдущим поколением.

Возможности управления включают возможности самовосстановления сети и движки ускорения NVIDIA In-Network Computing. Время простоя центра обработки данных снижено еще больше благодаря платформе NVIDIA UFM Cyber-AI.

Основанные на промышленных стандартах коммутаторы NVIDIA Quantum-2, поставки которых начнутся к концу 2021 года, имеют прямую и обратную совместимость, что обеспечивает простоту миграции и расширение существующих систем и программного обеспечения.

Производители инфраструктуры, включая Atos, DDN, Dell Technologies, Excelero, GIGABYTE, HPE, Lenovo, Penguin, QCT, Supermicro, VAST и WekaIO, планируют интегрировать коммутаторы Quantum-2 NDR 400Gb/s InfiniBand в свои корпоративные и HPC-системы. Поставщики облачных сервисов, включая Azure, также применяют технологию InfiniBand.

Технология Magnum IO GPUDirect Storage устанавливает прямую связь между памятью GPU и накопителем. Благодаря прямому доступу снижаются задержки при работе с приложениями и полностью используется пропускная способность сетевых адаптеров, при этом снижается нагрузка на CPU и контролируется потребление данных.

2018: Анонс Nvidia HGX-2

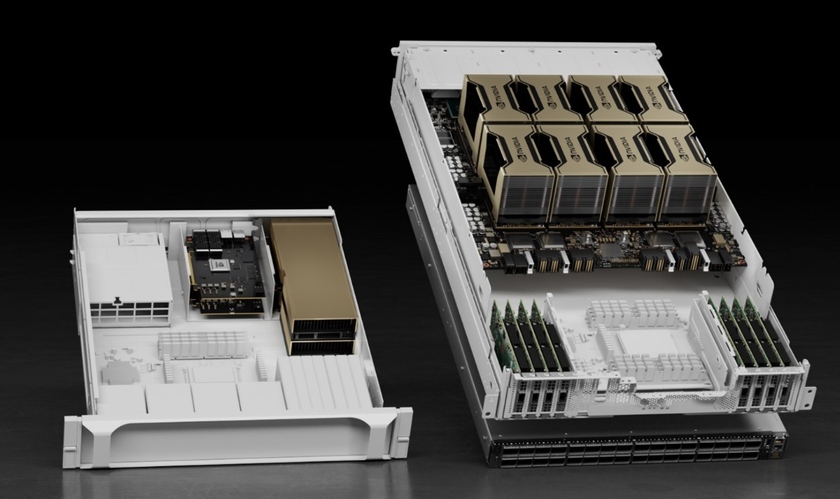

Компания Nvidia 30 мая 2018 года представила Nvidia HGX-2 — унифицированную вычислительную платформу для высокопроизводительных вычислений и вычислений в области искусственного интеллекта. HGX-2 входит в семейство GPU-ускоренных серверных платформ Nvidia — экосистемы сертифицированных серверов, предназначенных для широкого спектра вычислений ИИ, HPC и ускоренных вычислений с оптимальной производительностью.

Облачная серверная платформа HGX-2 с поддержкой произвольных вычислений (multi-precision) обеспечивает гибкость, необходимую для вычислений будущего. Она позволяет выполнять вычисления высокой точности FP64 и FP32 для научных исследований и моделирования, а также поддерживает FP16 и Int8 для обучения ИИ и инференса. Такая универсальность отвечает требованиям растущего числа приложений, сочетающих HPC-вычисления и работу с ИИ, пояснили в компании.

| | Мир вычислений изменился, — отметил Дженсен Хуанг (Jensen Huang), основатель и генеральный директор Nvidia. — Эффект от масштабирования CPU заметно сократился, в то время как спрос на вычисления растет драматическими темпами. Платформа Nvidia HGX-2 на базе GPU с тензорными ядрами предлагает мощные универсальные возможности, позволяющие выполнять как HPC, так и вычисления для ИИ для решения насущных глобальных вызовов. | |

По словам разработчиков, скорость обучения ИИ-сетей на платформе HGX-2 достигает 15,5 ты. изображений в секунду в бенчмарке ResNet-50, что позволяет заменить до 300 серверов на базе CPU.

Платформа поддерживает такие передовые возможности, как интерфейс Nvidia NVSwitch, который позволяет объединить 16 GPU Nvidia Tesla V100 с тензорными ядрами, превратив их в единый гигантский графический процессор со скоростью вычислений 2 петафлопса в задачах ИИ. Первой системой на базе платформы HGX-2 стала недавно анонсированная система Nvidia DGX-2.

Как ожидают в Nvidia, HGX-2 станет ключевым компонентом передовых вычислительных систем производителей для задач HPC и ИИ. Так, четыре производителя серверов — Lenovo, QCT, Supermicro и Wiwynn — объявили о планах выпуска собственных систем на базе HGX-2 в 2018 году. Кроме того, четыре мировых ODM-производителя — Foxconn, Inventec, Quanta и Wistron — также готовят к выпуску системы на базе HGX-2, предназначенные для установки в крупнейшие облачные дата-центры.

2017: Запуск Nvidia HGX

В мае 2017 года Nvidia запустила партнерскую программу с ведущими ODM-производителями — Foxconn, Inventec, Quanta и Wistron, чтобы быстрее удовлетворить рыночный спрос на облачные вычисления для задач искусственного интеллекта (ИИ).

В рамках партнерской программы Nvidia HGX Nvidia предоставляет каждому ODM-производителю ранний доступ к референсной архитектуре Nvidia HGX, технологиям вычислений на GPU и руководствам по проектированию. Модель HGX – та же, что используется и в Microsoft Project Olympus, системах Facebook Big Basin и суперкомпьютерах для задач ИИ NVIDIA DGX-1.

HGX – это референсная архитектура для поставщиков облачных решений, которые хотят перейти на новую платформу Nvidia GPU Cloud. Платформа Nvidia GPU упрощает доступ к полностью интегрированным и оптимизированным фреймворкам глубокого обучения, включая Caffe2, Cognitive Toolkit, MXNet и TensorFlow.

Используя HGX в качестве основы, ODM-партнеры в сотрудничестве с Nvidia могут быстрее создавать и выводить на рынок спектр GPU-ускоренных систем для гипермасштабируемых дата-центров. В рамках программы инженеры NVIDIA помогут ODM-производителям сократить время как на проектирование, так и на развертывание систем.

С помощью новых GPU на базе архитектуры Nvidia Volta, которая обеспечивает втрое более высокую производительность по сравнению с предшествующей архитектурой, ODM-производители могут удовлетворить рыночный спрос, выпустив новые продукты на базе новейших технологий Nvidia .

Гибкая модернизируемая система

Nvidia создала референсную архитектуру HGX, чтобы обеспечить производительность, эффективность и масштабируемость, необходимые для гипермасштабируемых облачных окружений. HGX поддерживает большой спектр конфигураций в зависимости от нагрузки и позволяет объединять графические и центральные процессоры в различных комбинациях для высокопроизводительных вычислений, обучения глубоких сетей и инференса.

Стандартная архитектура HGX включает восемь ускорителей Nvidia Tesla в форм-факторе SXM2, объединенных топологией cube mesh с помощью высокоскоростного интерфейса Nvidia NVLink и оптимизированных PCIe-топологий. Благодаря модульному дизайну, HGX-системы могут устанавливаться в существующие дата-центры во всем мире, при необходимости используя гипермасштабируемые CPU-узлы.

С HGX совместимы оба ускорителя Nvidia - Tesla P100 и V100. Поэтому системы на базе HGX можно будет обновить сразу же, как только процессоры V100 выйдут на рынок.